实验室在多模态人类意图融合研究中取得新进展,论文“A Novel Human-in-the-Loop Multimodal Intention Fusion Method for Human–Robot Interaction”被期刊IEEE Transactions on Automation Science and Engineering正式接受。

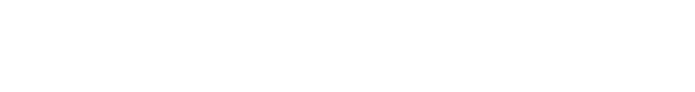

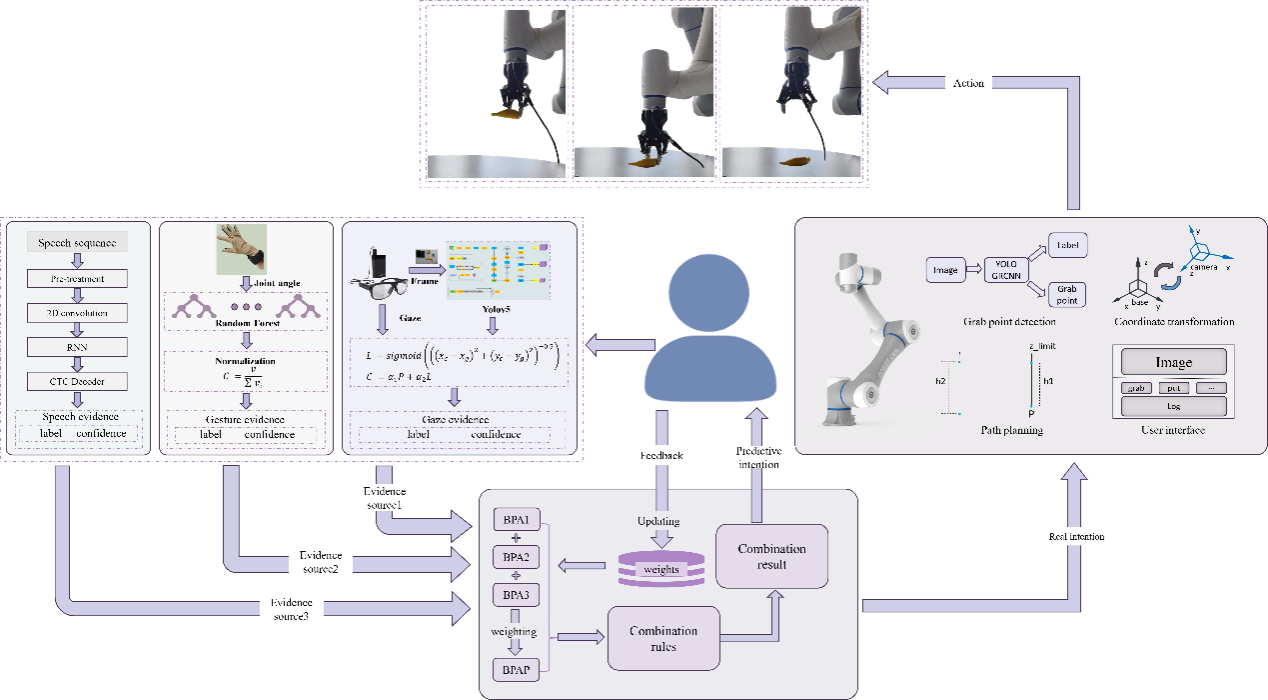

本研究针对多模态意图理解中普遍存在的信息冲突、识别准确率和难以满足用户偏好的问题,提出了HIL-MIF—一种人在环路的多模态意图融合方法,用于人机交互。该方法通过引入权重来代表用户对各种模式的偏好。通过这些权重评估融合过程中每种模态的贡献,然后通过组合规则获得最终结果。此外,用户反馈被整合到意图融合机制中,以自适应地调整这些权重,从而形成一个闭环系统,实现高度可靠的意图理解。此外,在多个交互过程中,权重会不断更新,以完成用户偏好的拟合。

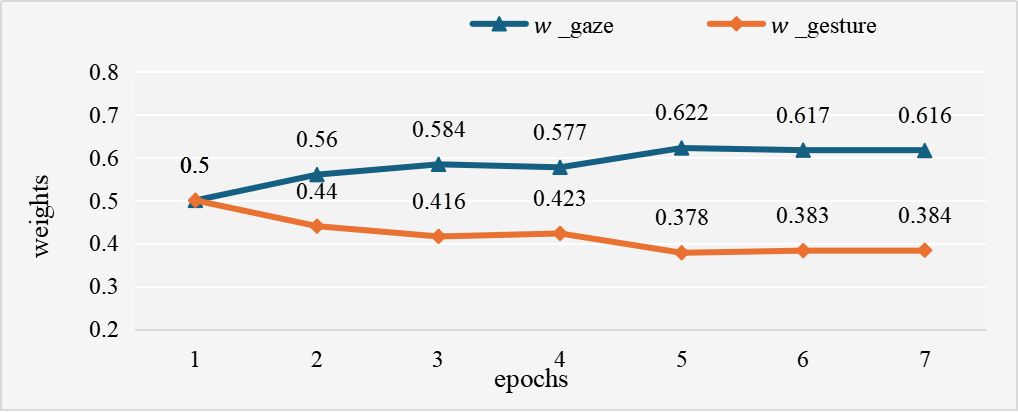

我们在各种条件下对该系统进行了评估。实验结果表明,本文提出的 HIL-MIF 在准确性和可靠性方面均优于其他常用多模态融合方法。HIL-MIF 能够调整不同通道的权重以适应用户偏好,从而提高交互的成功率和可靠性。用户调查显示,该系统能够满足用户多样化的交互需求,提供了一种更可靠、自然的人机交互方式。本文所设计的系统为多模态人机交互场景奠定了基础。

论文信息:Shuo Jiang, Wenbo Zhang, Jiahang Liu, Haonan Li, Zhipeng Wang, Yanmin Zhou, and Bin He. A Novel Human-in-the-Loop Multimodal Intention Fusion Method for Human–Robot Interaction. IEEE Transactions on Automation Science and Engineering. doi: 10.1109/TASE.2025.3580469.(2025)