实验室成果在《Scientific Data》上发表

2025年04月01日

实验室在如何获取多模态具身行为数据集取得了重要进展。相关研究成果以题为“Enhancing robotic skill acquisition with multimodal sensory data: A novel dataset for kitchen tasks”的论文,于2025年3月在线出版在《Scientific Data》(IF=5.8)。

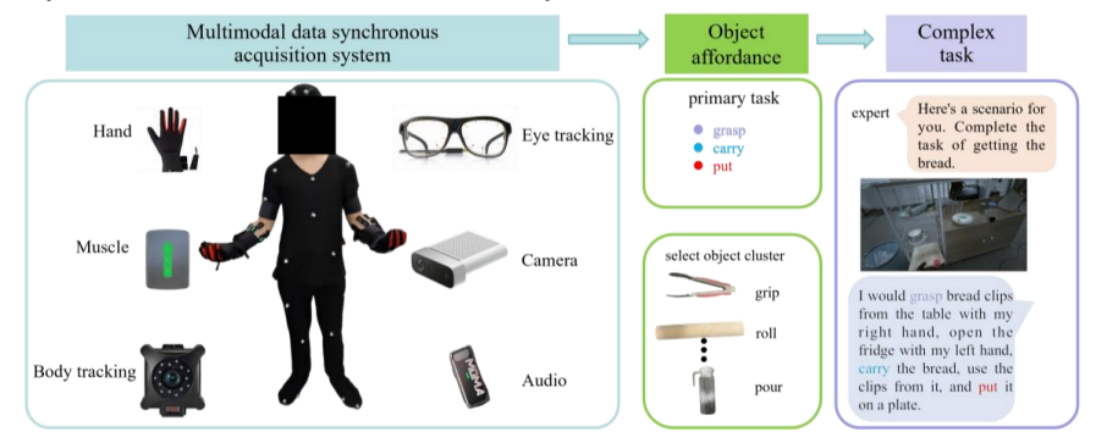

大语言模型的出现通过使机器人能够执行自然语言指令来完成任务,彻底改变了人机交互方式。然而,这些模型主要依赖单模态数据,限制了其整合多样化环境数据、生理数据和物理数据的能力。针对当前单模态数据集的局限性,本文研究了一种新颖全面的多模态数据采集方法,该方法能完整捕捉复杂真实厨房环境中人机交互的多维度特性。研究采集了20名成年人在动态场景中使用17种不同厨房工具时的多模态数据,包括人类触觉信息、肌电信号、音频数据、全身运动数据和眼动追踪数据。该数据集包含680个片段(约11小时),涵盖七种模态数据,并附有56,000条详细标注。

论文信息:Ren, R., Wang, Z., Yang, C. et al. Enhancing robotic skill acquisition with multimodal sensory data: A novel dataset for kitchen tasks. Sci Data 12, 476 (2025). https://doi.org/10.1038/s41597-025-04798-z.