实验室的研究团队在手-物体交互重建领域取得进展。相关研究成果以题为“Geometric-aware RGB-D representation learning for hand-object reconstruction”的论文被Expert Systems With Applications (IF=7.5)期刊录用。

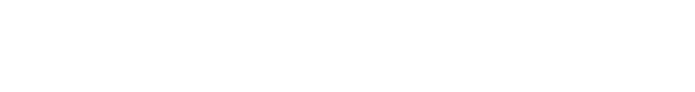

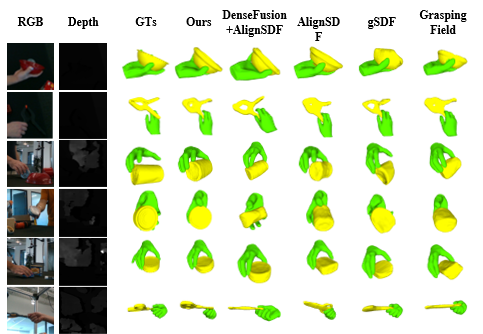

手-物体交互对于理解人类行为至关重要,广泛应用于机器人学习、虚拟现实和增强现实等领域。然而,由于相互遮挡、物体形状和姿态的变化以及透视投影引起的几何信息丢失,从单个图像重建手-物体交互具有挑战性。现有的方法经常难以捕捉手-物体交互的几何细节,特别是在光线差、对比度低和杂乱环境等具有挑战性的场景中。研究提出了一种隐式几何感知的RGB-D表示学习方法,利用自适应双向RGB-D特征融合(ABF)和几何傅里叶特征编码(GFFE),在特征提取和编码阶段增强了手-物体交互的神经隐式表示。实验结果表明,该方法在DexYCB和ObMan基准测试中显著优于现有方法,特别是在光线较差、低对比度、遮挡、反射、杂乱场景和复杂物体形状等挑战性条件下表现尤为出色。

论文信息:Jiajun Ma, Yanmin Zhou, Zhipeng Wang*, Hongrui Sang, Rong Jiang, Bin He, “Geometric-aware RGB-D representation learning for hand–object reconstruction”, Expert Systems with Applications, 2024, 257.