实验室在如何提高机器人情感交互中多视角面部表情识别的鲁棒性上的研究取得了进展。相关研究成果以题为“mFERMeta++ : Robust Multiview Facial Expression Recognition Based on Metahuman and Metalearning”的论文于2023年7月在线出版在《Advanced Intelligent Systems》(IF=7.4)。

面部表情是传达人类情绪的重要手段,准确识别面部表情可以及时反映人的精神状态和情绪信息。尽管现有许多表情识别系统能在可控的实验室环境中达到很高的准确率,但在现实世界中的应用部署却很复杂,尤其在自然人机交互领域,姿态的变化对表情识别带来了极大的挑战。

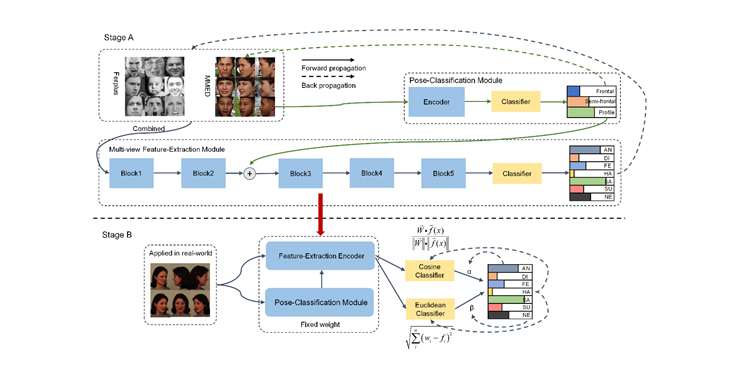

多视角面部表情识别(MFER)领域存在严重瓶颈,包括缺乏高质量的 MFER 数据集,以及模型在真实世界 MFER 场景中的鲁棒性有限。因此,本文建立了基于数字人的 MFER 数据集(MMED),有效解决了现有数据集数量和质量不足的问题。其次,我们提出了一种条件级联 VGG模型,它可以根据输入图像的姿态信息自适应地调整表情特征提取。最后,我们提出了一种训练和学习策略,将我们的 MMED 数据集与现实世界的数据集整合在一起,并利用提出的 Meta-Dist小样本学习方法将其快速部署到现实世界的应用场景中。在 KDEF 数据集上的实验表明,所提出的模型在多视角应用场景中表现出更强的鲁棒性,与Baseline模型相比,识别准确率提高了 28.68%。这表明所提出的 MMED 数据集能显著提高 MFER 模型的训练效率,更便于在实际应用中部署。

这项工作为 MFER 研究提供了一个可靠的数据集与虚实融合的研究思路,并为在现实世界中针对多视角表情的鲁棒表情识别奠定了研究基础。

论文信息:

S. Jiang, J. Liu, Y. Zhou, Z. Wang and B. He, " Robust Multiview Facial Expression Recognition Based on Metahuman and Metalearning," in Advanced Intelligent Systems, 2023, doi: 10.1002/aisy.202300210.(https://onlinelibrary.wiley.com/doi/epdf/10.1002/aisy.202300210)